人工智能迫使数据中心重新思考设计

随着人工智能在企业中的大规模应用,其后果之一是其消耗了数据中心更大比例的工作负载。

人工智能不仅将加速对数据中心的需求,为投资创造新的动力,而且还将对数据中心的可持续性战略和要部署的基础设施的性质产生影响。

例如,Tirias Research预测,按照目前的情况,到2028年,生成式人工智能数据中心服务器基础设施加上运营成本将超过7600万美元,是Amazon AWS目前估计年度运营成本的两倍多,占全球云服务市场的三分之一。

预测硬件计算性能将提高400%,这与Tirias估计的处理工作负载将增加50倍相比,相形见绌。

更高的密度

根据Schneider Electric的一份新白皮书,大型训练集群和小型边缘推理服务器的爆炸式增长,也将意味着向更高机架功率密度的转变。

白皮书称:“人工智能初创企业、企业、主机托管提供商和互联网巨头现在必须考虑这些密度对数据中心物理基础设施的设计和管理的影响。”

Schneider能源管理研究中心对人工智能对能源需求的影响做出了自己的预测。据估计,人工智能目前代表着4.3GW的电力需求,到2028年将以26%至36%的复合年增长率增长。

这将导致总需求达到13.5GW至20GW,是数据中心整体电力需求增长的两到三倍。到2028年,人工智能工作负载将占数据中心总能源的20%。

Schneider指出,虽然预计会比训练集群消耗更多的电量,但推理工作负载可以在各种机架密度下运行。

“另一方面,人工智能训练工作负载一直以非常高的密度运行,每个机架的功率在20-100 kW或更高。”

“网络需求和成本推动这些培训机架聚集在一起。这些极高功率密度的集群从根本上挑战了数据中心的电源、冷却、机架和软件管理设计。”

动力系统的挑战

Schneider概述了四个关键领域可能产生的影响:电源、冷却、机架和软件管理。

在电力方面,人工智能工作负载对开关设备和配电系统的动力系统提出了挑战。

目前使用的一些电压将被证明部署起来不切实际,而较小的配电块尺寸可能会浪费IT空间。较高的机架温度也会增加发生故障和危险的机会。

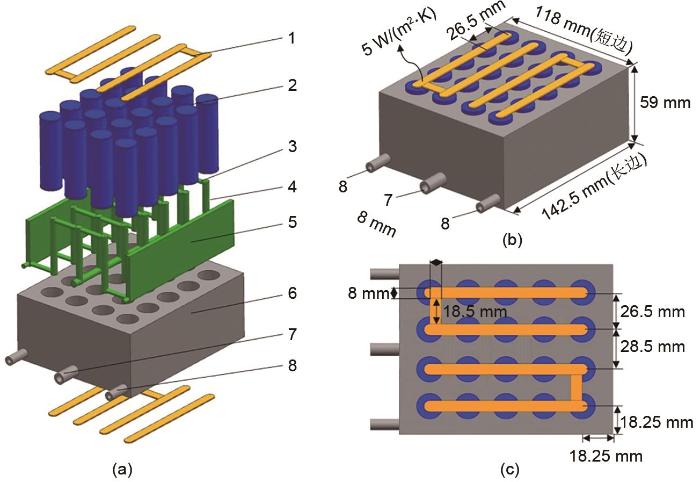

随着数据中心过渡到液体冷却,冷却将是至关重要的,也是需要进行重大改变的领域之一,半个多世纪以来,液体冷却一直用于专业高性能计算。

Schneider表示:“尽管在不久的将来,空气冷却仍将存在,但预测,从空气冷却到液体冷却的转变将成为具有人工智能集群的数据中心的首选或必要解决方案。”

“与空气冷却相比,液体冷却具有许多优点,例如提高处理器可靠性和性能、节省空间和更高的机架密度、管道中水的热惯性更大以及减少用水量。”

对于人工智能集群,服务器需要更深入,电力需求更大,冷却也更复杂。

因此,机架需要具有更大的密度和承重能力。

数字孪生

最后,DCIM、BMS和电气设计工具等软件工具将成为管理人工智能集群的关键。

适当配置和实施的软件可以提供数据中心的数字孪生,以识别功率限制和冷却资源的性能,从而为更好的布局决策提供信息。

在日益动态的环境中,容错空间越小,操作风险就会越高。因此,Schneider建议创建整个IT空间的数字孪生,包括机架中的设备和虚拟机。

”通过数字化添加或移动IT负载,可以验证是否有足够的电力、冷却和地板承重能力来支持。这为决策提供了信息,以避免资源搁浅,并最大限度地减少可能导致停机的人为错误。“

本文标题:人工智能迫使数据中心重新思考设计

本文链接://www.hsggzxc.com/faq3/860.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。